与字节国内业务并池,火山引擎「抢滩」AI赛道(2)

2023-04-26 来源:飞速影视

火山引擎对外称并不做大模型,谭待在接受另镜等媒体采访时表示,大模型还在发展初期,数据安全、内容安全、隐私保护、版权保护等许多问题需要努力解决。但可以预见,大模型将带动云上AI算力急剧增长,AI算力的工作负载与通用算力的差距会越来越小,这会为各家云厂商带来新的机会,同时也会为数据中心、软硬件栈、PaaS平台带来新的挑战。开启多云多模型时代

Distinct Mirror

对于与字节国内业务并池,字节跳动副总裁杨震原表示,这意味着未来可以在一个共享的资源池里面去调度资源,从而去提高整体资源利用率。

“未来将是多云多模型的时代”,谭待表示。谭待称,大模型需要大算力,虚拟化会带来资源损耗,规模越大就损耗越多。未来3年内,大规模的算力中心,都将形成“CPU GPU DPU”的混合算力结构,CPU负责通用计算,GPU负责AI计算,DPU负责资源卸载、加速和隔离,提升资源效率。谭待表示,如现在AI对各个行业、对各个场景的帮助是越来越大的。AI很多是代表的是GPU,非CPU异构计算的负载。这部分的负载占比确实会越来越大。以前GPU比CPU可能是1比10或1比9,未来这个占比可能会越来越高。AI是重点关注的方向之一,包括CPU场景有很多是要持续优化的。未来将是多云多模型的时代,火山引擎发布了分布式云原生平台、多云CDN管理平台、多云安全平台、混合云veStack等产品,助企业用好分布式云,高效应对多云、混合云、边缘云场景的分布式云原生管理的挑战。

此次原动力大会上,火山引擎发布了新一代自研DPU,实现计算、存储、网络的全组件卸载,释放更多资源给业务负载。火山引擎尽管是“最年轻”的云厂商,其自研DPU已达到业界领先水平,网络性能高达5000万pps转发能力、延迟低至20us。基于自研DPU的各类计算实例性能也有显著提升,例如适用于大模型分布式并行训练场景的GPU实例,相较上一代实例集群性能最高提升3倍以上。

聚焦三大核心要素

Distinct Mirror

大模型需要大算力和很好的工程能力,去解决千卡甚至万卡并行的训练问题。对于火山来说,一方面是算力的供给,另一方面是云原生机器学习平台,能够帮助企业去应用好算力,而且进一步去提升效率,去把大模型训练的又快又稳定。

火山引擎的产品理念是围绕云上增长三个核心要素,分别是敏捷迭代、数据驱动、体验创新。在敏捷迭代方面,火山引擎发布自研DPU等系列云产品,并推出支持万卡级大模型训练、微秒级延迟网络的新版机器学习平台,让大模型训练更稳更快。在数据驱动方面,火山引擎发布业界首个数据飞轮模式,数据飞轮核心是数据消费,数据消费一方面是构建数据应用能力,这里面就是AB测试、CDP、GMP这些事情。另一部分是构建数据平台的闭环,那就是大数据的组件。火山引擎围绕数据飞轮理念,升级发布了三款数据产品:管理驾驶舱Plus、云原生湖LAS和云原生Flink。在体验创新方面,ToB服务是要一个漫长的实践过程,但它积累起来以后会有很强的连续性。火山引擎短期考虑的还是怎么面向客户创造更多的价值,作为长期来看,要回归商业本质,云计算要成为一个盈利的业务。

为提供更多体验创新,火山引擎发布六款产品:云游戏产品、创意互动Vlog、AR互动营销、WTN(WebRTC传输网络)、虚拟数字人、音视频 云端一体解决方案veVOS。

相关影视

引擎

2010/大陆/剧情片

内心引力

2016/大陆/记录片

火并

1971/香港/动作片

业内前五

2014/美国/喜剧片

长白山天池水怪

2020/大陆/动作片

露西亚的愿望:抢救圣诞节

2020/其它/剧情片

转生贤者的异世界生活 ~获得第二职业,并成为世界最强~

2022/日本/日韩动漫

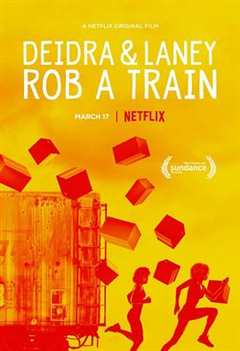

德蒂拉和兰尼抢劫了一辆火车

2017/美国/喜剧片

合作伙伴

本站仅为学习交流之用,所有视频和图片均来自互联网收集而来,版权归原创者所有,本网站只提供web页面服务,并不提供资源存储,也不参与录制、上传

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

www.fs94.org-飞速影视 粤ICP备74369512号