算法推荐的歧视与偏见

2023-05-01 来源:飞速影视

近日,牛津大学互联网研究院的一项新研究显示,算法正在基于我们的浏览行为推断一些敏感的个人特征,比如,种族、性别、性取向和宗教信仰。这些特征随后会被在线广告商加以利用,在推销产品和服务时瞄准或排除某些特定群体,或向他们提供不同价格,从而引发新的“歧视”。算法正在大规模、大范围地进入我们的生活,对广告商来说,智能算法通过对用户的浏览行为、消费习惯等数据的分析,将相关信息内容推送给最有可能与其互动的受众,帮助广告商更加快速到达精准受众群体。一些企业也通过智能算法,由机器承担繁杂的现实认知任务,以计算机的思维帮助企业实现定向招聘、人才筛选、公司决策等问题。智能算法对于普通用户的影响,主要通过个性化推送实现,这种方式有效地解决了信息过载的问题,满足用户潜在和实在的个性化需求。但与此同时,对于“算法偏见”“算法歧视”的讨论也不绝于耳。

连带歧视:更为隐蔽的算法歧视

基于数据分析的智能算法常常带来歧视等问题。算法广告中的种族歧视、性别歧视,以及“大数据杀熟”背后的价格歧视是生活中常见的几种算法偏见。有学者认为,将算法偏见仅仅定义为由于算法程序的片面性呈现在种族、性别、职业身份等之上的消极态度,未免稍显狭隘。他们指出,“算法偏见”是指算法程序在信息生产和分发过程失去客观中立的立场,影响公众对信息的客观全面认知。

牛津大学互联网研究院的这项研究则表明,广告商正在刻意规避以个体敏感特征(如性别、种族等)将目标受众进行分类,而是以貌似中性的特征将用户分成不同的人群,基于人群的类同性来提供不同的产品、价格与服务。主持该研究的学者桑德拉·瓦赫特将这种以中性特征划分人群所引发的算法歧视称为“连带歧视”。

桑德拉指出,根据英国现行的数据保护法规,广告商基于个人敏感特征(性别、种族等)来瞄准信息群体被视为非法。这就意味着以智能算法作为决策工具的企业需要通过其他类别数据的收集,达成对目标对象更为精准的分析,提供更加适合受众口味或有利于自身利益诉求实现的产品和服务。

而连带歧视则意味着,即使看似最无害的中立信息,也存在被滥用的风险。例如“一种放贷算法可能会认为养狗的人群和按时偿还贷款的人群之间存在正相关,因此会将‘养狗’作为一个中性变量,用来优先对某些人放贷”。也就是说,对于数据收集类型的限制并不必然带来算法歧视的减少,相反,这种歧视可能以更加隐蔽的形式存在着。

相关影视

傲慢与偏见与僵尸

2016/美国/恐怖片

独活女子的推荐

2021/日本/日本剧

独活女子的推荐3

2023/日本/日本剧

独活女子的推荐第二季

2022/日本/日本剧

傲慢与偏见

2005/法国/剧情片

傲娇与偏见

2017/大陆/喜剧片

傲慢与偏见第一季

1995/英国/欧美剧

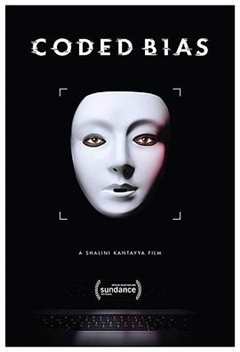

编码歧视

2020/美国/记录片

合作伙伴

本站仅为学习交流之用,所有视频和图片均来自互联网收集而来,版权归原创者所有,本网站只提供web页面服务,并不提供资源存储,也不参与录制、上传

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

www.fs94.org-飞速影视 粤ICP备74369512号