Midjourney 妙鸭相机 Gen2新玩法:10块钱一键图生视频(含教程)(15)

2023-12-21 来源:飞速影视

目前,最先进的视频模型在视觉质量和用户对生成内容的控制方面,仍然落后于图像模型。这不,研究人员想了个辙,把文生图模型推广到文本编辑视频上,搞了个新框架TokenFlow。

具体来说,在给定源视频和目标文本提示的情况下,研究人员的方法能生成与目标文本一致的高质量视频,同时保留输入视频的空间布局和动态效果。

主要方法是通过强制扩散特征空间的一致性,获得编辑视频的一致性。

根据模型中随时可用的帧间对应关系明确传播扩散特征,从而实现这一目标。因此新框架不需要任何训练或微调,可以直接与任何现成的文本到图像编辑方法相结合来使用,可谓事半功倍。

同时,团队还观察到,视频的时间一致性水平与其特征表示的时间一致性密切相关,这一点可以从下面的特征可视化图中看出。

自然视频的特征具有共享的时间一致性的特点,而当按帧编辑视频时,这种一致性就会被打破。新方法则能保证编辑后的视频与原始视频特征相同的特征一致性。

在编辑过程中,通过强化跨帧内部扩散特征的一致性,可以实现时间上一致的编辑。

为此,研究人员利用原始视频特征之间的对应关系,跨帧传播一小部分已编辑的特征。

即:给定输入视频I,研究人员通过反转每一帧,提取标记的方式,使用最近邻(NN)搜索提取帧间特征对应关系。

在每个去噪步骤中,研究人员会从噪声视频J_t中采样出关键帧,并使用扩展注意模块对其进行联合编辑。编辑后的标记集为T_base。

之后,再根据预先计算的原始视频特征的对应关系,在整个视频中扩散经过编辑的标记。

为了对J_t进行去噪处理,研究人员会将每一帧输入网络,并利用第二步获得的标记来替换生成的标记。

相关影视

美妙频道第一季

2018/日本/日韩动漫

小鸡快跑2:鸡块新时代

2023/英国/动画片

美妙频道第三季

2020/日本/日韩动漫

美妙频道第二季

2019/日本/日韩动漫

2023腾讯视频星光大赏

2023/大陆/大陆综艺

匿名者警视厅“键盘杀人”对策室

2021/日本/日本剧

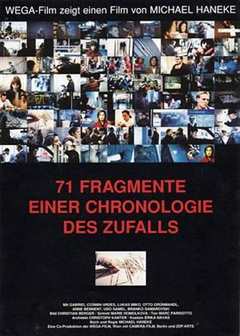

机遇编年史的71块碎片

1994/其它/剧情片

合作伙伴

本站仅为学习交流之用,所有视频和图片均来自互联网收集而来,版权归原创者所有,本网站只提供web页面服务,并不提供资源存储,也不参与录制、上传

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

www.fs94.org-飞速影视 粤ICP备74369512号