胡泳|在人工智能时代生存和成长(4)

2023-05-01 来源:飞速影视

但是在这个问题上,人类的精英是分裂的。同样有鼓吹AI的精英出来说AI有非常大的问题,比如霍金。霍金说人工智能有可能会毁灭整个人类文明。霍金去世前特别关心的是剑桥大学的未来研究中心,他说以往人类研究历史发现的真相只有一个,人类的历史就是一部愚蠢的历史,我们能不能反过来想一下人类在什么时候能够不愚蠢?所以人们转而研究智能的未来是令人欣喜的变化。剑桥大学的未来研究中心有一个非常简单的使命,就是研究人工智能在未来会不会毁灭人类。霍金在中心开幕的时候讲了一段话,他说人工智能的发展可能帮助人类消灭疾病、消灭贫困、阻止气候变化,但也可能产生人们不愿意看到的种种后果,包括产生自主武器、造成经济灾难,以及发展出与人类发生冲突时拥有自己意愿的机器。欧洲正在开展一些立法工作,围绕人工智能和机器人技术建立新规则。欧洲议会的议员会追问机器人会不会有电子人格,这是一个很严肃的问题。如果机器人有电子人格,我们造机器的时候一定要附加一个最后的开关,就是必须要有一个开关能够让机器人停止做某种事情。如果大家看过克拉克的著名科幻片《2001太空漫游》,对其中的人工智能电脑哈尔因为不能控制那个开关,结果把人类毁灭了。讨论到这里我们发现,如果机器有自己的人格,甚至企图对创造它的人造成伤害,我们该怎么办?这是霍金担忧的问题。

3月,欧盟有关方面与微软、IBM两家公司共同签署了《人工智能伦理罗马宣言》,该宣言指出人工智能技术应当尊重个人隐私,以可靠而无偏见的方式工作,并且考虑到所有人的需求。IBM执行副总裁认为这一举措表达了对人工智能及其社会影响的长期担忧

刚才说到精英群体观点的分裂,还有其他的代表人物,比如埃隆·马斯克。马斯克一边在研究AI,一边在谈AI的危险。他说人工智能的危险大于核武器的危险,为什么这么说呢?因为AI的能力远超出我们的想像,而且在以指数增长的速度进化。这里可以回应李开复的说法:“我们是人工智能专家,我们懂。”马斯克质问,你真的懂吗?那些所谓的AI专家,他们自以为知道的其实远比他们实际知道的多,他们以为的自己要比真实的自己聪明得多。我们每个人其实都是这样,人工智能的专家也毫不例外。

相关影视

超人高中生们即便在异世界也能从容生存!

2019/日本/日韩动漫

人工智能

2001/美国/科幻片

生存之民工

2005/大陆/国产剧

我的超能力没有存在感

2022/大陆/国产剧

只有爱能让我生存

2018/日本/爱情片

智能爱人粤语版

2021/香港/香港剧

在异世界获得超强能力的我,在现实世界照样无敌~等级提升改变人生命运~

2023/日本/日韩动漫

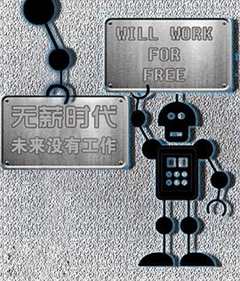

无薪时代—未来没有工作

2013/英国/记录片

合作伙伴

本站仅为学习交流之用,所有视频和图片均来自互联网收集而来,版权归原创者所有,本网站只提供web页面服务,并不提供资源存储,也不参与录制、上传

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

www.fs94.org-飞速影视 粤ICP备74369512号