特斯拉自动驾驶的底层逻辑(4)

2023-05-20 来源:飞速影视

不过,这仅仅是学习一个静态的信号,在汽车驾驶过程中会涌现无数静态和动态的信号,静态如路边大树、路障、电线杆等,动态的有行人、车辆等,而这些信号由摄像机捕捉到后交由神经网络训练、学习。目前特斯拉的自动驾驶神经网络已发展出九大主干神经(HydraNet)和48个神经网络,识别超过1000种目标。然而,仅仅让自动驾驶AI学会开车还不够,还得让它开得像人类老司机一般驾轻就熟、安全又平稳。

02

摆脱拐杖,Autopilot初长成

任何一位经验老道的司机,都能在不同路况下,轻易判断出前方车辆与我们的距离,从而为保障行车安全而留出一定车距。

但对传感器而言,要想判断物体远近必须要理解物体的深度,不然在他们眼中,距离我们10米和5米的两辆完全一样的车,就会被认为是一大一小的关系。

对此,有些车厂选择激光雷达路线来探测深度,而特斯拉则选择了纯视觉算法,模仿人类视觉来感知深度,不过特斯拉先是打造了毫米波雷达 视觉传感融合路线,直到今年5月,才正式官宣,拿掉毫米波雷达,上线纯视觉版本Autopilot。

此事一出,社会各界一片哗然,很多人不能理解特斯拉为何要拿掉单价才300元、又能为行车安全增添保障的高性价比雷达。殊不知,在特斯拉早期多传感器融合路线中,毫米波雷达的存在就犹如小孩的学步车,只是帮助神经网络来学习训练深度标注(annotate)。

在2019年自动驾驶发布会上,卡帕西是这样介绍毫米波雷达的,他说:“要想让神经网络学会预测深度,最好的方式还是通过深度标注的数据集进行训练,不过相对于人工标注深度,毫米波雷达反馈的深度数据精准度更高”,因此,引入毫米波雷达,实质是用以训练和提高神经网络对深度的预测。

值得一提的是,在他讲解时的背景幻灯片右下角上,清晰地注明了带有毫米波雷达的自动驾驶算法是“Semi-Automonous Self Driving”,翻译过来是,半自动驾驶,明显彼时的特斯拉Autopilot只是个半成品。

直到特斯拉视觉算法在预测物体的深度、速度、加速度的表现,达到可替代毫米波雷达的水平,特斯拉的视觉算法才算真正独立。

相关影视

雏逻辑:来自幸运逻辑

2017/日本/日韩动漫

驾驶我的车

2021/日本/剧情片

失去贝拉特斯的波利斯

2016/加拿大/剧情片

学会驾驶

2014/美国/喜剧片

无人驾驶

2010/大陆/剧情片

超速驾驶

2017/法国/动作片

X驾驶员

2016/美国/剧情片

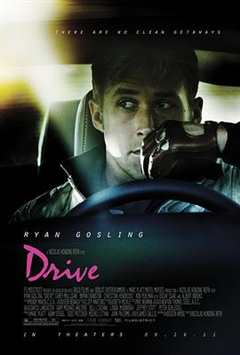

亡命驾驶

2011/美国/动作片

合作伙伴

本站仅为学习交流之用,所有视频和图片均来自互联网收集而来,版权归原创者所有,本网站只提供web页面服务,并不提供资源存储,也不参与录制、上传

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

www.fs94.org-飞速影视 粤ICP备74369512号