数字法治|潘芳芳:算法歧视的民事责任形态(2)

2023-05-01 来源:飞速影视

(一)算法歧视的侵权行为样态算法,也可以称之为自动化决策,是指利用个人信息对个人的行为习惯、兴趣爱好或者经济、健康、信用状况等,通过计算机程序自动分析、评估并进行决策的活动。以大数据和计算机程序设计为依托的算法决策程序的运用,无论是数据的收集和挖掘,还是算法程序的设计和使用阶段,都对应产生不同类型的算法歧视:既包括因直接的敏感数据使用和数据挖掘中社会固有刻板印象的再现而导致的“特征选择型”算法歧视,也包括对敏感数据相关联的数据的联合使用而导致的“偏见代理型”算法歧视,以及主要用于商业领域、以类型化和个性化推送为目标的“大数据杀熟型”算法歧视等。数据、算法程序和最终的算法决策结果之间,好比食材、食谱和菜肴之间的关系,菜肴是在按照食谱对食材类别、分量和添加程序等指导下做出来的。所以,当算法决策结果存在歧视现象时,既有可能是作为食材的变量因素——所使用的“数据”有问题,也可能是算法程序的设计不合适或存在纰漏。

适用广泛的同时伴有极高的风险系数,算法决策技术可能引致的算法歧视危机在世界范围内引发了广泛的关注和警惕。不同的国家和组织在技术与法律融合的基础上,都专门针对算法歧视风险的避免进行了设定,内容既涵盖抽象的原则、伦理要求,也有具体的制度和规则建议;既包括事前的预防和制止措施,也有事后的追责与救济机制;既强调内在自律,也重视外在他律。技术(风险)不分国界。当前,算法安全与算法歧视规制已经成为世界性的难题与挑战。上述不同国家、区域和组织所提出的各种安全标准和行为准则等,已得到我国社会公众、技术专家和规范制定者的广泛吸收和认可,无论是在交易习惯还是新出台的《个人信息保护法》中都有所体现。算法歧视的侵权责任建构,即以上述规范和文件中所创设的交易习惯和法律理念、原则、规则为基础和依据。具体而言,依据主体主观状态和行为样态的不同,可将算法歧视行为划分为通过积极的作为所实施的故意侵权行为和因过失违反作为义务而承担的过失侵权责任。

1.故意实施侵权行为:敏感数据使用

计算机程序的运行,遵循“GIGO”(Garbage In,Garbage Out)定律,转接到算法歧视场景下则变为“BIBO”(Bias In, Bias Out),即偏见进,偏见出——如果输入的数据是具有歧视性质的,那么输出的算法决策结果就必然带有歧视色彩。将部分可能造成歧视后果的“敏感数据”排除算法决策体系的自变量范畴,即“技术性脱敏”,已经成为规范领域反算法歧视的基本要求,是最容易操作和实现、操作过程可视化程度最高的一种途径和手段。

相关影视

芳芳郁金香

2003/法国/喜剧片

小芳的故事

1994/大陆/剧情片

正义的算法

2022/台湾/台湾剧

负有责任的孩子

2019/英国/剧情片

举证责任

2023/美国/记录片

法治中国

2017/大陆/记录片

治外法权

2015/韩国/动作片

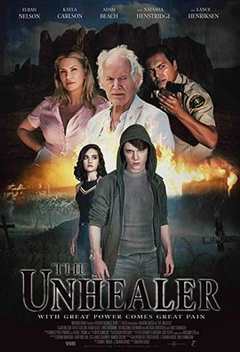

无法治愈

2020/美国/科幻片

合作伙伴

本站仅为学习交流之用,所有视频和图片均来自互联网收集而来,版权归原创者所有,本网站只提供web页面服务,并不提供资源存储,也不参与录制、上传

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

www.fs94.org-飞速影视 粤ICP备74369512号