数字法治|潘芳芳:算法歧视的民事责任形态(4)

2023-05-01 来源:飞速影视

《个人信息保护法》便是在数字化时代背景下,国家为了保护处于弱势地位的信息主体的相关权益而制定和实施的,带有公法性质的特别法规范。数字化时代背景下,无论是数据和信息瑕疵,程序设计的结果导向,还是算法程序“黑箱”属性下的透明度缺失,都容易引发算法歧视危机,被决策者遭受歧视性待遇的风险系数颇高。行为人引入算法决策系统辅助、部分或者全部地代替人类决策,开启了被决策者可能遭受歧视性待遇的危险。“权责一致”的逻辑和理念下,即便没有故意实施算法歧视的主观意图,作为招致风险的源头,行为人也理应为自己这种“先前危险行为”负担一定的作为义务,采取合理必要的、具备期待可能性的保护和防范措施,预防和避免算法歧视现象的发生,并在风险预防和制止义务履行存在瑕疵、被决策者遭受了歧视性待遇时,为被决策者的损失承担侵权赔偿责任。

(1)算法程序运行的影响评估与合规审计义务

《个人信息保护法》明确要求,个人信息处理者应当定期对个人信息处理活动是否遵守法律、行政法规的情况进行合规审计。并且,在利用个人信息进行自动化决策过程中,要对个人信息处理活动在事前进行影响评估。算法以数据和决策程序为依托而运行,所以,对算法程序运行的影响评估与合规审计,意味着行为人要在信息安全与程序公平两方面展开核查。

自动化算法决策过程中,对信息的审查与评估,一方面,是为了保障个人信息的安全;另一方面,也是为了避免关联数据联合使用下“偏见代理型”算法歧视的发生。对于个人信息安全保护的影响评估,内容主要包括信息的处理目的、处理方式等是否合法、正当、必要,对个人的影响及风险程度,以及所采取的安全保护措施是否合法、有效与风险程度相适应三个方面。此外,在有些算法决策过程中,行为人输入和使用的虽然是经过脱敏处理的客观、中立数据,但这些数据可能会与敏感数据存在一定的关联。对这部分较为隐秘的敏感性“关联数据”的采用,最终也可能会产生歧视性的决策结果,这种情况下所发生的算法歧视,被学者称之为“关联歧视”或“偏见代理型”算法歧视。典型案例,如看似中立、客观的邮政编码信息,却可能会与某特殊种族人们的集中居住地之间存在一定的关联,依此类邮政编码信息所进行的算法决策,结果很可能就会带有种族歧视色彩。

因此,在数据方面进行评估与审计的另外一个重要内容,即为敏感性“关联数据”的检测与排查。即除了明显、可视的典型歧视类敏感数据外,还应结合算法程序的原理和试运行后果,发现并排除这类可能与歧视性敏感数据相关的“关联数据”,确保输入和使用的数据信息与决策结果之间具备合理关联性,且不会对某一特定群体产生不合理的差别对待。此外,若决策程序所使用的数据信息存在不全、错误或者更新不及时等问题时,也会使被决策对象遭受不公平的歧视性待遇。为避免此类歧视发生的可能性,除了类别和范围限制外,行为人还应当保证所使用数据和信息的质量和准确度,确保所使用的数据不存在错误、遗漏或更新不及时等问题。

相关影视

芳芳郁金香

2003/法国/喜剧片

小芳的故事

1994/大陆/剧情片

正义的算法

2022/台湾/台湾剧

负有责任的孩子

2019/英国/剧情片

举证责任

2023/美国/记录片

法治中国

2017/大陆/记录片

治外法权

2015/韩国/动作片

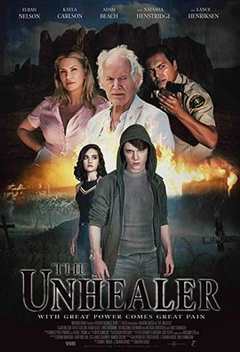

无法治愈

2020/美国/科幻片

合作伙伴

本站仅为学习交流之用,所有视频和图片均来自互联网收集而来,版权归原创者所有,本网站只提供web页面服务,并不提供资源存储,也不参与录制、上传

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

www.fs94.org-飞速影视 粤ICP备74369512号