数字法治|潘芳芳:算法歧视的民事责任形态(5)

2023-05-01 来源:飞速影视

除数据和信息相关的义务外,算法决策程序自身也应当接受专业的评估、审查与检验,以确保程序的实施和运行不会对某一特定群体产生不合理的差别待遇。算法的广泛开发与利用与社会公共利益密切相关,不合理、不公平的算法程序运行可能会引发大范围的社会风险。所以,针对不同场景下的算法决策技术的使用,“审慎适用”和精细化的“分类监管”已经成为我国算法行业的基本模式和思路。2018年,在中国科学院软件研究所的牵头之下,电子技术标准化研究院发布了《人工智能深度学习算法评估规范》。作为国内发布的首个算法评估标准,该规范以算法技术使用的具体场景为划分依据,确定了不同层级、不同数目的指标,搭建了初步的算法评估指标体系,成功地迈出了尝试和探索场景化、精细化的算法治理的第一步。此外,其他新近出台的一系列法律、规章、条例中,也都有专门的条款对不同场景中的算法应用进行治理和规制,如《数据安全管理办法(征求意见稿)》中针对个性化的新闻和广告推送、差异化的商品与服务定价的治理;《电子商务法》针对搜索类算法和商品、服务的竞价排名的规范;《信息安全技术、个人信息安全规范(草案)》中针对个性化展示及退出相关的规制等。行为人在引入算法决策程序辅助或者代替人类进行决策的过程中,应当以应用场景为基础,对照不同的规范性文件的要求进行风险的评估与审计,并根据评估和审计的结果确定下一步的行为。

以现行规范性文件为基础和依据展开算法歧视影响的评估与审计,并非履行作为义务的唯一路径,行为人还有其他多元的途径和方式可供选择。行为人既可以邀请领域内的专家对程序的设计逻辑和原理进行评估,也可以委托有资格和能力的组织和机构进行检验和认证;在具备现实基础的情况下,为确保评估与审查的效果,行为人还可以采取试运行的方式,接受非领域专家和相关利益群体的监督、检查与批评。但无论采取何种途径和方式,行为人都需要谨慎进行,只有在确保算法程序运行的各个环节都不会产生歧视性后果的基础上,才可正式引入算法决策程序,投入运行和使用。

总的而言,行为人在算法决策系统投入前,对数据和程序所展开的审查与评估,既可以有效避免歧视的发生,又能够满足算法决策审查与监督机制的要求,为后期可能发生的纠纷和争议的处理提供证明和依据,是行为人理应承担的一项非常重要的义务。

(2)算法程序的有限透明和可解释性义务

保证算法决策的透明度以及处理结果的公平、合理,是对行为人最基本的要求和其理应遵守的基本原则。为了保障被决策者的权益不受算法决策的侵害,以欧盟为代表的相当部分的国家和区域在相关规制中,都通过赋予被决策者新型权利的模式来化解双方在信息或者权力上的不对称局面。我国针对个人信息保护的规范制定中,立法者针对自动化算法决策技术的使用也明确规定,被决策者认为算法技术的使用会对其权益造成重大影响的,有权拒绝行为人通过算法技术作出决定,或者要求行为人对其个人信息处理规则进行解释和说明。

相关影视

芳芳郁金香

2003/法国/喜剧片

小芳的故事

1994/大陆/剧情片

正义的算法

2022/台湾/台湾剧

负有责任的孩子

2019/英国/剧情片

举证责任

2023/美国/记录片

法治中国

2017/大陆/记录片

治外法权

2015/韩国/动作片

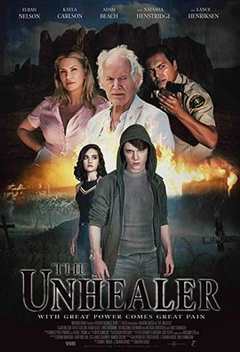

无法治愈

2020/美国/科幻片

合作伙伴

本站仅为学习交流之用,所有视频和图片均来自互联网收集而来,版权归原创者所有,本网站只提供web页面服务,并不提供资源存储,也不参与录制、上传

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

若本站收录的节目无意侵犯了贵司版权,请发邮件(我们会在3个工作日内删除侵权内容,谢谢。)

www.fs94.org-飞速影视 粤ICP备74369512号